In der Welt der Sprachmodelle gab es im Oktober wieder einige Fortschritte und Veränderungen:

- Grok2 von X.AI - Plötzlich in den Top 15!

- Gemini 1.5 Flash 8B - Der Fortschritt für lokale Modelle setzt sich fort

- Neue Claude Sonnet 3.5 und Haiku 3.5 - Diese Modelle werden immer besser

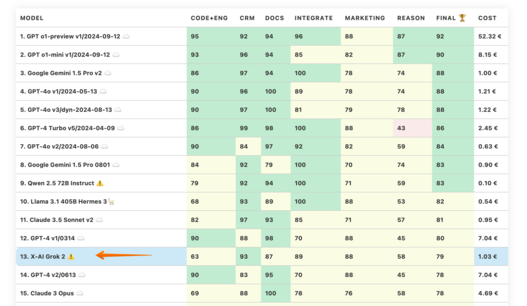

LLM Benchmarks | Oktober 2024

Die Benchmarks bewerten die Modelle in Bezug auf ihre Eignung für die digitale Produktentwicklung. Je höher die Punktezahl, desto besser.

☁️ - Cloud-Modelle mit proprietärer Lizenz

✅ - Open-Source-Modelle, die lokal ohne Einschränkungen ausgeführt werden können

🦙 - Lokale Modelle mit Llama2-Lizenz

Kann das Modell Code generieren und bei der Programmierung helfen?

Die geschätzten Kosten für die Ausführung der Arbeitslast. Für cloud-basierte Modelle berechnen wir die Kosten gemäß der Preisgestaltung. Für lokale Modelle schätzen wir die Kosten auf Grundlage der GPU-Anforderungen für jedes Modell, der GPU-Mietkosten, der Modellgeschwindigkeit und des operationellen Overheads.

Wie gut unterstützt das Modell die Arbeit mit Produktkatalogen und Marktplätzen?

Wie gut kann das Modell mit großen Dokumenten und Wissensdatenbanken arbeiten?

Kann das Modell problemlos mit externen APIs, Diensten und Plugins interagieren?

Wie gut kann das Modell bei Marketingaktivitäten unterstützen, z.B. beim Brainstorming, der Ideenfindung und der Textgenerierung?

Wie gut kann das Modell in einem gegebenen Kontext logisch denken und Schlussfolgerungen ziehen?

Die Spalte "Speed" gibt die geschätzte Geschwindigkeit des Modells in Anfragen pro Sekunde an (ohne Batching). Je höher die Geschwindigkeit, desto besser.

| Modell | Code | Crm | Docs | Integrate | Marketing | Reason | Ergebnis | Kosten | Speed |

|---|---|---|---|---|---|---|---|---|---|

| 1. GPT o1-preview v1/2024-09-12 ☁️ | 95 | 92 | 94 | 96 | 88 | 87 | 92 | 52.32 € | 0.08 rps |

| 2. GPT o1-mini v1/2024-09-12 ☁️ | 93 | 96 | 94 | 85 | 82 | 87 | 90 | 8.15 € | 0.16 rps |

| 3. Google Gemini 1.5 Pro v2 ☁️ | 86 | 97 | 94 | 100 | 78 | 74 | 88 | 1.00 € | 1.18 rps |

| 4. GPT-4o v1/2024-05-13 ☁️ | 90 | 96 | 100 | 89 | 78 | 74 | 88 | 1.21 € | 1.44 rps |

| 5. GPT-4o v3/dyn-2024-08-13 ☁️ | 90 | 97 | 100 | 81 | 79 | 78 | 88 | 1.22 € | 1.21 rps |

| 6. GPT-4 Turbo v5/2024-04-09 ☁️ | 86 | 99 | 98 | 100 | 88 | 43 | 86 | 2.45 € | 0.84 rps |

| 7. GPT-4o v2/2024-08-06 ☁️ | 90 | 84 | 97 | 92 | 82 | 59 | 84 | 0.63 € | 1.49 rps |

| 8. Google Gemini 1.5 Pro 0801 ☁️ | 84 | 92 | 79 | 100 | 70 | 74 | 83 | 0.90 € | 0.83 rps |

| 9. Qwen 2.5 72B Instruct ⚠️ | 79 | 92 | 94 | 100 | 71 | 59 | 83 | 0.10 € | 0.66 rps |

| 10. Llama 3.1 405B Hermes 3🦙 | 68 | 93 | 89 | 100 | 88 | 53 | 82 | 0.54 € | 0.49 rps |

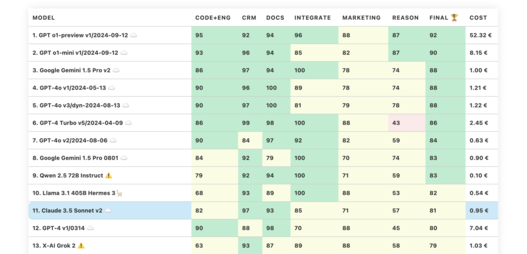

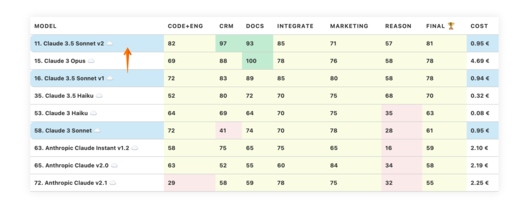

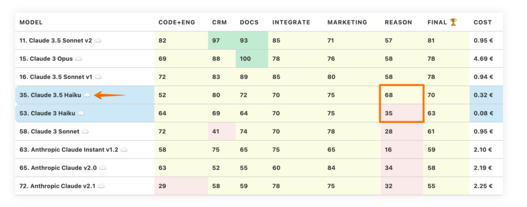

| 11. Claude 3.5 Sonnet v2 ☁️ | 82 | 97 | 93 | 85 | 71 | 57 | 81 | 0.95 € | 0.09 rps |

| 12. GPT-4 v1/0314 ☁️ | 90 | 88 | 98 | 70 | 88 | 45 | 80 | 7.04 € | 1.31 rps |

| 13. X-AI Grok 2 ⚠️ | 63 | 93 | 87 | 89 | 88 | 58 | 79 | 1.03 € | 0.31 rps |

| 14. GPT-4 v2/0613 ☁️ | 90 | 83 | 95 | 70 | 88 | 45 | 78 | 7.04 € | 2.16 rps |

| 15. Claude 3 Opus ☁️ | 69 | 88 | 100 | 78 | 76 | 58 | 78 | 4.69 € | 0.41 rps |

| 16. Claude 3.5 Sonnet v1 ☁️ | 72 | 83 | 89 | 85 | 80 | 58 | 78 | 0.94 € | 0.09 rps |

| 17. GPT-4 Turbo v4/0125-preview ☁️ | 66 | 97 | 100 | 85 | 75 | 43 | 78 | 2.45 € | 0.84 rps |

| 18. GPT-4o Mini ☁️ | 63 | 87 | 80 | 70 | 100 | 65 | 78 | 0.04 € | 1.46 rps |

| 19. Meta Llama3.1 405B Instruct🦙 | 81 | 93 | 92 | 70 | 75 | 48 | 76 | 2.39 € | 1.16 rps |

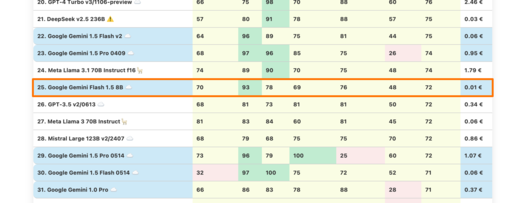

| 20. GPT-4 Turbo v3/1106-preview ☁️ | 66 | 75 | 98 | 70 | 88 | 60 | 76 | 2.46 € | 0.68 rps |

| 21. DeepSeek v2.5 236B ⚠️ | 57 | 80 | 91 | 78 | 88 | 57 | 75 | 0.03 € | 0.42 rps |

| 22. Google Gemini 1.5 Flash v2 ☁️ | 64 | 96 | 89 | 75 | 81 | 44 | 75 | 0.06 € | 2.01 rps |

| 23. Google Gemini 1.5 Pro 0409 ☁️ | 68 | 97 | 96 | 85 | 75 | 26 | 74 | 0.95 € | 0.59 rps |

| 24. Meta Llama 3.1 70B Instruct f16🦙 | 74 | 89 | 90 | 70 | 75 | 48 | 74 | 1.79 € | 0.90 rps |

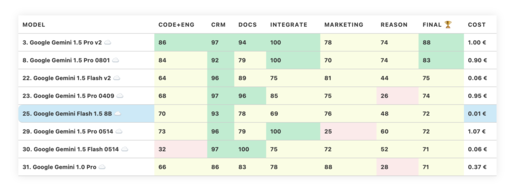

| 25. Google Gemini Flash 1.5 8B ☁️ | 70 | 93 | 78 | 69 | 76 | 48 | 72 | 0.01 € | 1.19 rps |

| 26. GPT-3.5 v2/0613 ☁️ | 68 | 81 | 73 | 81 | 81 | 50 | 72 | 0.34 € | 1.46 rps |

| 27. Meta Llama 3 70B Instruct🦙 | 81 | 83 | 84 | 60 | 81 | 45 | 72 | 0.06 € | 0.85 rps |

| 28. Mistral Large 123B v2/2407 ☁️ | 68 | 79 | 68 | 75 | 75 | 70 | 72 | 0.86 € | 1.02 rps |

| 29. Google Gemini 1.5 Pro 0514 ☁️ | 73 | 96 | 79 | 100 | 25 | 60 | 72 | 1.07 € | 0.92 rps |

| 30. Google Gemini 1.5 Flash 0514 ☁️ | 32 | 97 | 100 | 75 | 72 | 52 | 71 | 0.06 € | 1.77 rps |

| 31. Google Gemini 1.0 Pro ☁️ | 66 | 86 | 83 | 78 | 88 | 28 | 71 | 0.37 € | 1.36 rps |

| 32. Meta Llama 3.2 90B Vision🦙 | 74 | 84 | 87 | 78 | 71 | 32 | 71 | 0.23 € | 1.10 rps |

| 33. GPT-3.5 v3/1106 ☁️ | 68 | 70 | 71 | 78 | 78 | 58 | 70 | 0.24 € | 2.33 rps |

| 34. GPT-3.5 v4/0125 ☁️ | 63 | 87 | 71 | 78 | 78 | 43 | 70 | 0.12 € | 1.43 rps |

| 35. Claude 3.5 Haiku ☁️ | 52 | 80 | 72 | 70 | 75 | 68 | 70 | 0.32 € | 1.24 rps |

| 36. Qwen1.5 32B Chat f16 ⚠️ | 70 | 90 | 82 | 78 | 78 | 20 | 69 | 0.97 € | 1.66 rps |

| 37. Cohere Command R+ ☁️ | 63 | 80 | 76 | 70 | 70 | 58 | 69 | 0.83 € | 1.90 rps |

| 38. Gemma 2 27B IT ⚠️ | 61 | 72 | 87 | 70 | 89 | 32 | 69 | 0.07 € | 0.90 rps |

| 39. Mistral 7B OpenChat-3.5 v3 0106 f16 ✅ | 68 | 87 | 67 | 70 | 88 | 25 | 67 | 0.32 € | 3.39 rps |

| 40. Gemma 7B OpenChat-3.5 v3 0106 f16 ✅ | 63 | 67 | 84 | 60 | 81 | 46 | 67 | 0.21 € | 5.09 rps |

| 41. Meta Llama 3 8B Instruct f16🦙 | 79 | 62 | 68 | 70 | 80 | 41 | 67 | 0.32 € | 3.33 rps |

| 42. Mistral 7B OpenChat-3.5 v2 1210 f16 ✅ | 63 | 73 | 72 | 69 | 88 | 30 | 66 | 0.32 € | 3.40 rps |

| 43. Mistral 7B OpenChat-3.5 v1 f16 ✅ | 58 | 72 | 72 | 70 | 88 | 33 | 65 | 0.49 € | 2.20 rps |

| 44. GPT-3.5-instruct 0914 ☁️ | 47 | 92 | 69 | 62 | 88 | 33 | 65 | 0.35 € | 2.15 rps |

| 45. GPT-3.5 v1/0301 ☁️ | 55 | 82 | 69 | 78 | 82 | 26 | 65 | 0.35 € | 4.12 rps |

| 46. Llama 3 8B OpenChat-3.6 20240522 f16 ✅ | 76 | 51 | 76 | 60 | 88 | 38 | 65 | 0.28 € | 3.79 rps |

| 47. Mistral Nemo 12B v1/2407 ☁️ | 54 | 58 | 51 | 100 | 75 | 49 | 64 | 0.03 € | 1.22 rps |

| 48. Meta Llama 3.2 11B Vision🦙 | 70 | 71 | 65 | 70 | 71 | 36 | 64 | 0.04 € | 1.49 rps |

| 49. Starling 7B-alpha f16 ⚠️ | 58 | 66 | 67 | 70 | 88 | 34 | 64 | 0.58 € | 1.85 rps |

| 50. Qwen 2.5 7B Instruct ⚠️ | 48 | 77 | 80 | 60 | 69 | 47 | 63 | 0.07 € | 1.25 rps |

| 51. Llama 3 8B Hermes 2 Theta🦙 | 61 | 73 | 74 | 70 | 85 | 16 | 63 | 0.05 € | 0.55 rps |

| 52. Yi 1.5 34B Chat f16 ⚠️ | 47 | 78 | 70 | 70 | 86 | 26 | 63 | 1.18 € | 1.37 rps |

| 53. Claude 3 Haiku ☁️ | 64 | 69 | 64 | 70 | 75 | 35 | 63 | 0.08 € | 0.52 rps |

| 54. Liquid: LFM 40B MoE ⚠️ | 72 | 69 | 65 | 60 | 82 | 24 | 62 | 0.00 € | 1.45 rps |

| 55. Meta Llama 3.1 8B Instruct f16🦙 | 57 | 74 | 62 | 70 | 74 | 32 | 61 | 0.45 € | 2.41 rps |

| 56. Qwen2 7B Instruct f32 ⚠️ | 50 | 81 | 81 | 60 | 66 | 31 | 61 | 0.46 € | 2.36 rps |

| 57. Mistral Small v3/2409 ☁️ | 43 | 75 | 71 | 75 | 75 | 26 | 61 | 0.06 € | 0.81 rps |

| 58. Claude 3 Sonnet ☁️ | 72 | 41 | 74 | 70 | 78 | 28 | 61 | 0.95 € | 0.85 rps |

| 59. Mixtral 8x22B API (Instruct) ☁️ | 53 | 62 | 62 | 100 | 75 | 7 | 60 | 0.17 € | 3.12 rps |

| 60. Mistral Pixtral 12B ✅ | 53 | 69 | 73 | 60 | 64 | 40 | 60 | 0.03 € | 0.83 rps |

| 61. Codestral Mamba 7B v1 ✅ | 53 | 66 | 51 | 100 | 71 | 17 | 60 | 0.30 € | 2.82 rps |

| 62. Inflection 3 Productivity ⚠️ | 46 | 59 | 39 | 70 | 79 | 61 | 59 | 0.92 € | 0.17 rps |

| 63. Anthropic Claude Instant v1.2 ☁️ | 58 | 75 | 65 | 75 | 65 | 16 | 59 | 2.10 € | 1.49 rps |

| 64. Cohere Command R ☁️ | 45 | 66 | 57 | 70 | 84 | 27 | 58 | 0.13 € | 2.50 rps |

| 65. Anthropic Claude v2.0 ☁️ | 63 | 52 | 55 | 60 | 84 | 34 | 58 | 2.19 € | 0.40 rps |

| 66. Qwen1.5 7B Chat f16 ⚠️ | 56 | 81 | 60 | 50 | 60 | 36 | 57 | 0.29 € | 3.76 rps |

| 67. Mistral Large v1/2402 ☁️ | 37 | 49 | 70 | 78 | 84 | 25 | 57 | 0.58 € | 2.11 rps |

| 68. Microsoft WizardLM 2 8x22B ⚠️ | 48 | 76 | 79 | 50 | 62 | 22 | 56 | 0.13 € | 0.70 rps |

| 69. Qwen1.5 14B Chat f16 ⚠️ | 50 | 58 | 51 | 70 | 84 | 22 | 56 | 0.36 € | 3.03 rps |

| 70. MistralAI Ministral 8B ✅ | 56 | 55 | 41 | 85 | 68 | 30 | 56 | 0.02 € | 1.02 rps |

| 71. MistralAI Ministral 3B ✅ | 50 | 48 | 39 | 92 | 60 | 41 | 55 | 0.01 € | 1.02 rps |

| 72. Anthropic Claude v2.1 ☁️ | 29 | 58 | 59 | 78 | 75 | 32 | 55 | 2.25 € | 0.35 rps |

| 73. Llama2 13B Vicuna-1.5 f16🦙 | 50 | 37 | 55 | 60 | 82 | 37 | 53 | 0.99 € | 1.09 rps |

| 74. Mistral 7B Instruct v0.1 f16 ☁️ | 34 | 71 | 69 | 59 | 62 | 23 | 53 | 0.75 € | 1.43 rps |

| 75. Mistral 7B OpenOrca f16 ☁️ | 54 | 57 | 76 | 25 | 78 | 27 | 53 | 0.41 € | 2.65 rps |

| 76. Meta Llama 3.2 3B🦙 | 52 | 71 | 66 | 70 | 44 | 14 | 53 | 0.01 € | 1.25 rps |

| 77. Google Recurrent Gemma 9B IT f16 ⚠️ | 58 | 27 | 71 | 60 | 56 | 23 | 49 | 0.89 € | 1.21 rps |

| 78. Codestral 22B v1 ✅ | 38 | 47 | 44 | 78 | 66 | 13 | 48 | 0.06 € | 4.03 rps |

| 79. Llama2 13B Hermes f16🦙 | 50 | 24 | 37 | 74 | 60 | 42 | 48 | 1.00 € | 1.07 rps |

| 80. IBM Granite 34B Code Instruct f16 ☁️ | 63 | 49 | 34 | 70 | 57 | 7 | 47 | 1.07 € | 1.51 rps |

| 81. Mistral Small v2/2402 ☁️ | 33 | 42 | 45 | 92 | 56 | 8 | 46 | 0.06 € | 3.21 rps |

| 82. DBRX 132B Instruct ⚠️ | 43 | 39 | 43 | 77 | 59 | 10 | 45 | 0.26 € | 1.31 rps |

| 83. NVIDIA Llama 3.1 Nemotron 70B Instruct🦙 | 68 | 54 | 25 | 74 | 28 | 21 | 45 | 0.09 € | 0.53 rps |

| 84. Mistral Medium v1/2312 ☁️ | 41 | 43 | 44 | 61 | 62 | 12 | 44 | 0.81 € | 0.35 rps |

| 85. Meta Llama 3.2 1B🦙 | 32 | 40 | 33 | 40 | 68 | 51 | 44 | 0.02 € | 1.69 rps |

| 86. Llama2 13B Puffin f16🦙 | 37 | 15 | 44 | 70 | 56 | 39 | 43 | 4.70 € | 0.23 rps |

| 87. Mistral Small v1/2312 (Mixtral) ☁️ | 10 | 67 | 63 | 52 | 56 | 8 | 43 | 0.06 € | 2.21 rps |

| 88. Microsoft WizardLM 2 7B ⚠️ | 53 | 34 | 42 | 59 | 53 | 13 | 42 | 0.02 € | 0.89 rps |

| 89. Mistral Tiny v1/2312 (7B Instruct v0.2) ☁️ | 22 | 47 | 59 | 38 | 62 | 8 | 39 | 0.05 € | 2.39 rps |

| 90. Gemma 2 9B IT ⚠️ | 45 | 25 | 47 | 34 | 68 | 13 | 38 | 0.02 € | 0.88 rps |

| 91. Meta Llama2 13B chat f16🦙 | 22 | 38 | 17 | 60 | 75 | 6 | 36 | 0.75 € | 1.44 rps |

| 92. Mistral 7B Zephyr-β f16 ✅ | 37 | 34 | 46 | 59 | 29 | 4 | 35 | 0.46 € | 2.34 rps |

| 93. Meta Llama2 7B chat f16🦙 | 22 | 33 | 20 | 60 | 50 | 18 | 34 | 0.56 € | 1.93 rps |

| 94. Mistral 7B Notus-v1 f16 ⚠️ | 10 | 54 | 25 | 52 | 48 | 4 | 32 | 0.75 € | 1.43 rps |

| 95. Orca 2 13B f16 ⚠️ | 18 | 22 | 32 | 22 | 67 | 20 | 30 | 0.95 € | 1.14 rps |

| 96. Mistral 7B v0.1 f16 ☁️ | 0 | 9 | 48 | 53 | 52 | 12 | 29 | 0.87 € | 1.23 rps |

| 97. Mistral 7B Instruct v0.2 f16 ☁️ | 11 | 30 | 54 | 12 | 58 | 8 | 29 | 0.96 € | 1.12 rps |

| 98. Google Gemma 2B IT f16 ⚠️ | 33 | 28 | 16 | 57 | 15 | 20 | 28 | 0.30 € | 3.54 rps |

| 99. Microsoft Phi 3 Medium 4K Instruct 14B f16 ⚠️ | 5 | 34 | 30 | 11 | 47 | 8 | 22 | 0.82 € | 1.32 rps |

| 100. Orca 2 7B f16 ⚠️ | 22 | 0 | 26 | 20 | 52 | 4 | 21 | 0.78 € | 1.38 rps |

| 101. Google Gemma 7B IT f16 ⚠️ | 0 | 0 | 0 | 9 | 62 | 0 | 12 | 0.99 € | 1.08 rps |

| 102. Meta Llama2 7B f16🦙 | 0 | 5 | 22 | 3 | 28 | 2 | 10 | 0.95 € | 1.13 rps |

| 103. Yi 1.5 9B Chat f16 ⚠️ | 0 | 4 | 29 | 9 | 0 | 8 | 8 | 1.41 € | 0.76 rps |

Grok 2 Beta from X-AI

Grok-2 Beta von xAI hat sich überraschend schnell zu einem leistungsfähigen Modell entwickelt. Während die vorherige Version kaum brauchbar war, hat Grok-2 Beta nun einen Platz unter den Top 15 erreicht. In unseren Benchmarks, die Aufgaben aus verschiedenen Sprachmodell-Anwendungen umfassen, zeigte das Modell insgesamt solide Leistungen. Besonders hervorzuheben ist seine verbesserte Fähigkeit zum logischen Schlussfolgern.

Das Modell erreicht eine Leistung, die nahe an älteren Versionen von GPT-4 liegt, bleibt jedoch hinter dem Qwen2.5-72B-Instruct zurück, das heruntergeladen und auf eigener Hardware betrieben werden kann.

Dennoch sind diese Entwicklungen positiv. Es zeigt sich, dass nahezu jedes Unternehmen mit ausreichend vielfältigen Daten und Zugang zu ausreichender Rechenleistung in der Lage ist, ein Modell zu entwickeln, das in die Top 20 unserer Benchmarks gelangt.

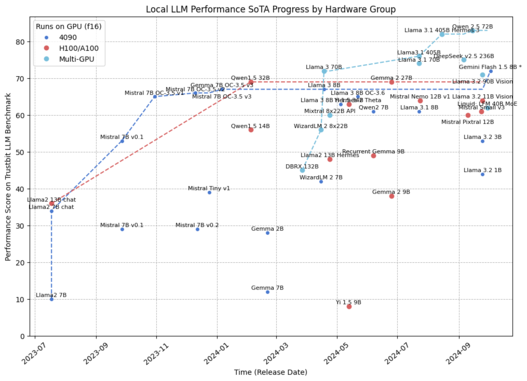

Gemini 1.5 Flash 8B

Wir haben in unserem September-LLM-Benchmark über die neuen Modelle der Llama-3.2-Serie gesprochen, die den Stand der Technik für lokale Modelle erheblich vorangetrieben haben. Der Fortschritt setzt sich fort:

Google hat das neue Gemini-1.5-Flash-Modell veröffentlicht, das in unseren Produktbenchmarks beeindruckende Ergebnisse zeigt. Dieses 8-Milliarden-Parameter-Modell erreicht eine Leistung, die mit GPT-3.5 oder Llama 3 70B vergleichbar ist und fast das Niveau des regulären 1.5 Flash erreicht.

Das Gemini 1.5 Flash-8B Modell von Google demonstriert den Fortschritt des Unternehmens in der Entwicklung großer Sprachmodelle (LLMs). Es ist das kostengünstigste Modell innerhalb der Gemini-Reihe und erreicht dennoch eine hohe Platzierung im Vergleich zu anderen Gemini-LLMs.

Eine wesentliche Einschränkung dieses Modells ist jedoch seine geschlossene Natur. Obwohl die Modellgröße von 8 Milliarden Parametern bekannt ist, ist es nicht möglich, die Gewichte herunterzuladen und das Modell lokal auszuführen. Dennoch kann Gemini 1.5 Flash kostengünstig genutzt werden. Die Geschichte zeigt, dass Errungenschaften eines Unternehmens oft bald von anderen wiederholt werden. Daher können wir in Zukunft mit weiteren kleinen Modellen dieser Qualität rechnen, die idealerweise lokal einsetzbar sind.

Claude Sonnet 3.5 and Haiku 3.5

Anthropic hat Aktualisierungen für die beiden Modelle in seinem Portfolio veröffentlicht:

- Mittel: Sonnet 3.5

- Klein: Haiku 3.5

Sonnet 3.5 ist derzeit das leistungsstärkste Modell von Anthropic in unserem Benchmark und ist auf Platz 11 aufgestiegen.

Im Vergleich zur vorherigen Version von Sonnet 3.5 bietet die aktuelle Version eine verbesserte Befolgung von Anweisungen und arbeitet besser mit Code, sowohl beim Schreiben als auch bei komplexeren technischen Aufgaben.

Claude 3.5 Sonnet v2 ist insgesamt ein solides Modell, aber man kann eine bessere Qualität zu einem niedrigeren Preis erzielen – zum Beispiel durch die Nutzung von GPT-4o oder den Einsatz des lokalen Qwen 2.5.

Claude 3.5 Haiku ist eine weitere Verbesserung der Haiku-Serie. Das Modell hat durchweg bessere Bewertungen erhalten (außer in der Kategorie Code+Engineering). Der größte Fortschritt war im Bereich Reasoning: von 35 auf 68! Dies ist der höchste Reasoning-Wert unter allen Modellen von Anthropic. Könnte dies auf eine neue Architektur in der nächsten Claude-Serie hinweisen?

Zusätzliche Fakten zur Untermauerung dieser Theorie: Das Haiku-Modell war das letzte Modell, das veröffentlicht wurde, und es kostet zudem viermal so viel wie die vorherige Haiku-Version. Änderungen in der Kostenstruktur von LLMs sind meist mit grundlegenden Änderungen in der Architektur verbunden.

Aufgrund der Preiserhöhung gehört Haiku nicht mehr zur Kategorie „intelligent und extrem günstig“. Inzwischen findet man bessere Modelle wie GPT-4o mini oder Google Gemini 1.5 Flash 8B.

Der allgemeine Trend steigender Qualität innerhalb der Modellreihen setzt sich fort. Mal sehen, ob das verbesserte Reasoning auch in anderen Modellversionen von Anthropic auftauchen wird.

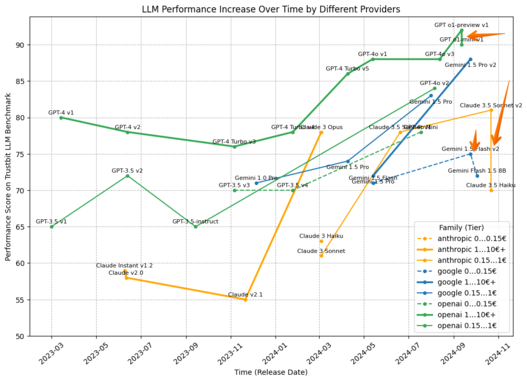

Trends

Apropos Trends: Werfen Sie einen Blick auf diesen interessanten Meta-Trend. OpenAI, Google und Sonnet haben in den letzten zwei Monaten neue Modelle der unteren Leistungsklassen in höhere Preiskategorien eingeführt. Dadurch entsteht der Eindruck, dass die Leistung der LLMs innerhalb dieser Kategorien tatsächlich abnimmt.

Dies könnte potenziell auf eine Kombination aus drei Faktoren hindeuten:

- LLM-Anbieter beginnen, ihre Preisgestaltung basierend auf Kosten und Nutzung zu optimieren.

- Es ist nicht mehr möglich, ausschließlich über Qualität zu konkurrieren, ohne den Rechenaufwand zu erhöhen (stoßen wir hier möglicherweise an die Grenzen der Transformer-Architektur?).

- Unsere Preisstufen für die Kategorien wurden nicht gut gewählt. Wir werden das gesamte Diagramm überarbeiten müssen.

Und wenn wir Gemini 1.5 Flash 8B in die Karte der lokal-fähigen Modelle eintragen, ergibt sich das untenstehende Bild, das einen deutlichen Leistungssprung im aktuellen Stand der Technik markiert.

Wir sind gespannt, wie sich die Dinge im November 2024 weiterentwickeln. Wir halten Sie natürlich auf dem Laufenden!

Transformieren Sie Ihre digitalen Projekte mit den besten KI-Sprachmodellen!

Entdecken Sie die transformative Kraft der besten LLM und revolutionieren Sie Ihre digitalen Produkte mit KI! Bleiben Sie zukunftsorientiert, steigern Sie die Effizienz und sichern Sie sich einen klaren Wettbewerbsvorteil. Wir unterstützen Sie dabei, Ihren Business Value auf das nächste Level zu heben.

Martin WarnungSales Consultant

martin.warnung@timetoact.at

Erfahren Sie mehr

ChatGPT & Co: September-Benchmarks für Sprachmodelle

ChatGPT & Co: November-Benchmarks für Sprachmodelle

ChatGPT & Co: Dezember-Benchmarks für Sprachmodelle

ChatGPT & Co: Jänner-Benchmarks für Sprachmodelle

Knowledge Graphs: vernetzte Daten als Innovationsmotor

AI for social good

In 8 Schritten zu AI-Innovationen im Unternehmen

Fehler in der Entwicklung von AI-Assistenten

8 Tipps zur Entwicklung von AI-Assistenten

Die Zukunft der KI: Enterprise RAG Challenge

Microsoft Azure-Ressourcen automatisch skalieren

Artificial Intelligence (AI) mit Spurhalteassistent im Griff

Business Innovation und Digitale Transformation mit AI

Braucht KI eine digitale Identität?

Krisenbewältigung & Aufbau einer nachhaltigen Zukunft mit KI

Google Workspace: KI-gestützte Arbeit für jedes Unternehmen

Highlights vom AI Action Summit 2025 in Paris

KI für alle: Wirtschaftliche Chancen mit generativer KI

Deep Learning: Ein Beispiel aus dem öffentlichen Dienst

Artificial Intelligence – No more experiments?!

KI Workshops für Unternehmen

Insights: Hackathon von „Applications & Data“

Der Leitfaden für Führungskräfte für generative KI

The ROI of Gen AI

Galuba & Tofote: KI-basierte Marktanalyse-Lösung swarmsoft

Miyu – die zentrale Sprachintelligenz

Webinar AI in der Praxis: KI für Unternehmen in der Zukunft

Lizenzmanagement fest im Griff - Das sollten Sie wissen!

In 6 Schritten zur passenden Data Analytics-Lösung

AWS Cloud: So optimieren Sie Ihre Kosten mit IBM Turbonomic!

Amazon EC2: Performance richtig messen und optimieren!

Elastic Block Storage: Performance und Kosten optimieren

Azure Cloud: Kosten mit IBM Turbonomic optimieren!

Eventreihe: KI Governance

Was Sie von Copilot erwarten können – und was nicht

Mit Microsoft Copilot in die Zukunft des Arbeitens

Dokumentenmanagement mit GPT optimieren

Best Practices für Copilot for Microsoft 365

Graphentechnologie

ESG-Tagebuch | Wissenstransfer & Kommunikation | Teil 2

Neues Datenschutzgesetz – Schutz vor Sanktionen dank IAM

Responsible AI: Ein Leitfaden für ethische KI-Entwicklung

Google Threat Intelligence

KI - Was Deutschland tun muss, um den Tech-Turbo zu zünden

Given/When/Then und ATDD - Eine Win-Win-Win-Situation!?

Warum ist Inline-CSS und JavaScript-Code so schlecht?

8 Tipps für ein erfolgreiches Automatisierungsprojekt

IBM Cloud Pak for Data Accelerator

ESA: Data Factory, die Single Source of Truth

Die HÜBNER-Gruppe startet ihre KI-Reise

AI & Data Science

KI Governance

Wer benötigt ein Intranet?

Esprit – auf dem Weg zur Data-driven-Company

Standardisiertes Datenmanagement bei TRUMPF

IAV erreicht ISO/IEC 5230 Zertifizierung

VYSYO – Zeit- & Kostenersparnisse dank neuester Technologien

Portfoliomanagement und Projektbudgetplanung/-kontrolle

Interaktives Onlineportal identifiziert passende Mitarbeiter

Bosch – Advanced Web Analytics für den globalen Mischkonzern

Managed Service Support für optimales Lizenzmanagement

TIMETOACT unterstützt KC Risk bei Benchmarking & Reporting

Globale Performance, lokale Stärke: OVHcloud macht’s möglich

Künstliche Intelligenz im Treasury Management

Gemini Prompting Guide 101

Microsoft Fabric: Für wen sich der Einstieg lohnt

Automatisierter Rechnungseingang bei Kapsch

MAIN adaptiert automatisierte Rechnungseingangslösung

Mit IBM FileNet zum modernen Dokumentenarchiv

Automatisierte Planung von Transportwegen

Automatisierte Eingangrechnungsverarbeitung mit JobRouter®

Whitepaper: Eine Einführung ins API Management

Rodenstock: Moderne Technologien und KI für Beratersoftware