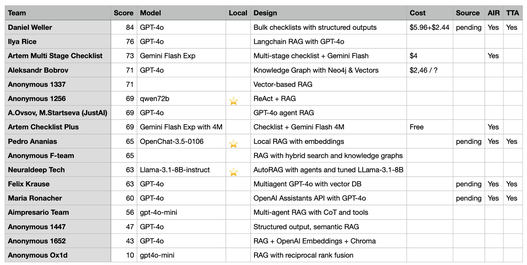

Daniel hat zugestimmt, den Quellcode für seine Lösung zu veröffentlichen. Sobald dieser verfügbar ist, werden wir das Github-Repository mit den Links aktualisieren. Der Status der Quellcode-Freigabe ist in der Source-Spalte zu sehen.

Daniels Lösung verwendet das GPT-4o-Modell mit strukturierten Ausgaben. Während der Vorbefüllungsphase profitiert sie davon, dass die möglichen Fragetypen in Form von öffentlich freigegebenem Code des Fragegenerators allen Teilnehmern zur Verfügung standen. So haben wir eine Checkliste mit möglichen Informationstypen erstellt, die extrahiert werden sollen, die Datentypen mit strukturierten Ausgaben erzwungen und dann alle Dokumente durchlaufen, um die notwendigen Informationen zu extrahieren. Große Dokumente wurden basierend auf der Größe aufgeteilt.

In der Phase der Beantwortung von Fragen gehen wir jede Frage durch und übergeben sie zusammen mit den vorab ausgefüllten Checklisten-Daten an GPT-4o. Die resultierende Antwort wird erneut mithilfe strukturierter Ausgaben in das richtige Schema geformt.

Die Lösung war etwas kostspielig. Die Vorbefüllung der 20 PDFs verbrauchte fast 6 Dollar, während das Beantworten von 40 Fragen 2,44 Dollar kostete.

In dieser Challenge setzen wir keine Kostenlimits für die Lösungen, ermutigen die Teilnehmer jedoch, die Kosten zu erfassen und zu teilen. Die Leser können dann die resultierenden Lösungen nach ihren eigenen Kriterien priorisieren.

Zweitbeste Lösung - Klassisches RAG mit GPT-4o

Die zweitbeste Lösung stammt von Ilya Rice. Sie erzielte 76 Punkte und erreichte dies mit GPT-4o und einem klassischen, auf Langchain basierenden RAG. Es wurde eines der besten Embedding-Modelle verwendet – text-embedding-3-large von OpenAI und benutzerdefinierte Chain of Thought-Prompts. Die Lösung nutzte fitz für das Textparsing und chunkte die Texte nach Zeichenanzahl.

Drittbeste Lösung - Checklisten mit Gemini Flash

Die drittbeste Lösung wurde von Artem Nurmukhametov bereitgestellt. Seine Lösung war architektonisch ähnlich der von Daniel, verwendete jedoch eine mehrstufige Verarbeitung für die Checklisten. Es wurde das Gemini Flash-Modell von Google verwendet, um das System zu steuern.

Die Lösung war ebenfalls kostspielig und verbrauchte 4 Dollar für den vollständigen Testlauf.

Wie Sie bemerkt haben, nutzten 2 der 3 besten Lösungen das Checklistenmuster und die Wissenszuordnung, um vom im Voraus bekannten Domain-Wissen zu profitieren. Während dies im Geschäftsbereich üblich ist (man kann Domänengetriebene Gestaltung und iterative Produktentwicklung verwenden, um ein ähnliches Detailniveau zu erfassen), stellt dies klassische RAG-Systeme vor Herausforderungen.

Um dies auszugleichen, werden wir in der nächsten Runde der Enterprise RAG Challenge den Fragegenerator überarbeiten, um mehr Variabilität zu bieten und es dadurch prohibitiver zu machen, "zu schummeln", indem man einfach Wissenszuordnung verwendet.

Beste On-Premise-Lösung

Wie Sie bemerkt haben, haben die meisten Lösungen das GPT-4o-LLM von OpenAI verwendet. Laut unseren Benchmarks ist dies eines der besten und kosteneffektivsten LLMs, die derzeit verfügbar sind.

In der realen Welt sind Unternehmen jedoch manchmal an Lösungen interessiert, die vollständig vor Ort ausgeführt werden können. Dies kann aus verschiedenen Gründen gewünscht sein: Kosten, IP-Schutz oder Compliance.

Lokale Lösungen bringen jedoch einige Nachteile mit sich – lokale Modelle wie Llama sind weniger leistungsfähig als Cloud-basierte Modelle wie OpenAI GPT-4 oder Claude Sonnet 3.5. Um dies auszugleichen, beginnen lokale KI-Systeme, fortschrittliche Techniken zu nutzen, die manchmal nur bei lokalen Modellen möglich sind – präzise Steuerung, Feinabstimmung (vollständige Feinabstimmung, nicht die Adapter, die OpenAI verwendet), die Verwendung von Expertenmischungen und Ensembles oder eine breite Strahlensuche.

Es kann schwierig sein, die effektive Genauigkeit von stark unterschiedlichen Ansätzen zu vergleichen. Diese Enterprise RAG Challenge ermöglicht es, sie auf derselben Basis zu vergleichen.

Der 6. Platz ging an ein vollständig lokales System mit einer Punktzahl von 69. Der Abstand zu dem Gewinner ist viel geringer, als wir erwartet haben!

Unter der Haube verwendet dieses System das Qwen-72B-LLM, das in einigen Teilen Europas und Asiens recht beliebt ist. Die Gesamtarchitektur basiert auf ReAct-Agent-Loops von LangChain mit einem RAG-gesteuerten Abfrage-Engine. Tabellendaten aus PDFs wurden in XML umgewandelt, und für das Text-Chunken wurde der RecursiveCharacterTextSplitter verwendet.

In der Tabelle gibt es zwei weitere Lösungen, die vollständig vor Ort ausgeführt werden können. Diese sind in der Spalte „Local“ mit einem ⭐ gekennzeichnet.

Runde 2: Diesen Herbst!

Die erste Runde wurde in einem kleinen Kreis von Fachleuten durchgeführt, um das Erlebnis zu testen und zu optimieren. Die Resonanz war viel besser, als wir erwartet hatten.

Wir planen, die nächste Runde der Enterprise RAG Challenge später im Herbst auszurichten. Diese Runde wird öffentlich angekündigt und beinhaltet ein paar kleine Balance-Änderungen:

Der Fragegenerator wird neu ausbalanciert, um weniger Fragen zu erzeugen, die zu einer N/A-Antwort führen. Einige solcher Fragen werden jedoch beibehalten, um Halluzinationsfälle zu erkennen.

Wir werden mehr Fragen generieren und eine größere Vielfalt an möglichen Fragen sicherstellen. Dies wird den Wettbewerb für Ansätze, die auf Wissenszuordnung und dem Checklist-LLM-Muster basieren, anspruchsvoller machen.

Alle Änderungen werden vor Beginn des Wettbewerbs öffentlich gemacht und als Open Source geteilt. Jeder Teilnehmer wird dieses Wissen nutzen können, um sich auf den Wettbewerb vorzubereiten.

Zusätzlich wird der Quellcode der Lösungen von TIMETOACT GROUP Österreich für alle zugänglich gemacht, um davon zu profitieren.

Wir werden auch versuchen, mehr Daten von den Teilnehmern zu sammeln und diese konsistenter zu gestalten.

All dies sollte die Ergebnisse der nächsten Runde wertvoller machen und dazu beitragen, unser gemeinsames Verständnis darüber zu verbessern, was es in der Praxis braucht, um hochwertige KI-Lösungen für Unternehmen zu entwickeln.

Strategischer Ausblick

Wir nähern uns dem Ende der Sommerferien und einer neuen Periode für Unternehmen. Was können wir in den kommenden Monaten in der Welt der „LLMs für Unternehmen“ erwarten?

Zunächst einmal werden sich die architektonischen Ansätze zur Lösung von Kundenproblemen weiterentwickeln. Wie wir in der RAG Challenge gesehen haben, gibt es keine einzelne beste Option, die alle anderen deutlich übertrifft. Radikal unterschiedliche Architekturen konkurrieren derzeit: Lösungen basierend auf Wissenszuordnung, klassischen vektorbasierenden RAGs, Systemen mit speziellen Agenten und Wissensgraphen.

Allein durch den Blick auf die Architektur ist es nicht möglich, im Voraus zu sagen, ob es die beste Lösung sein wird. Auch die Anzahl der Codezeilen ist kein klarer Indikator.

Basierend allein auf der Architektur gibt es weiterhin Raum für Qualitätsverbesserungen bei LLM-gesteuerten Lösungen.

LLM-Muster und -Praktiken werden jedoch nicht der einzige Faktor sein, der zukünftige Qualitätsverbesserungen vorantreibt. Wir dürfen nicht vergessen, dass große Sprachmodelle kontinuierlich besser und günstiger werden.